Метод трансформації класифікаційних міток зображення в сегментаційні маски

Основний зміст сторінки статті

Анотація

Задача бінарної або багато класової сегментації зображення постає в багатьох областях промисловості, медицини, сільського господарства та інших прикладних областях діяльності людини. На даний момент існує велика кількість алгоритмів машинного навчання, які можуть бути використані для цього, проте найбільш ефективним підходом на сьогодні є згорткові нейронні мережі. Водночас нейронні мережі потребують більших тренувальних вибірок в порівнянні з класичними алгоритми машинного навчання. Водночас накопичення тренувальної вибірки потребує великої кількості людських і фінансових ресурсів, а також часу. Отже постає задача дослідити методи зменшення кількості ресурсів для накопичення тренувального набору даних.

Попередні дослідження в цій сфері були присвячені методам часткового навчання або ж навчання без вчителя. Проте всі вони потребують накопичення певної тренувальної вибірки - масок для зображень. В даному дослідженні буде розглянуто інший підхід - трансформація класифікаційної розмітки (міток класів) в сегментаційну (маски зображень). Важливо зазначити, що подібні підходи достатньо нові та малодосліджені. Запропонований метод не потребує накопичення масок зображень, а значить і великої кількості ресурсів для їх збору. Розглянутий метод грунтується на алгоритмі GradCam, який дає можливість отримати активаційну маску зображення, маючи лише мітку классу. Проте для подальшого використання отриманої маски, необхідно застосувати ряд перетворень для покращення якості сегментації. Для підтвердження ефективності запропонованого методу були проведені експерименти на задачі сегментації дефектів на листах сталі — Kaggle-Severstal: Steel Defect Detection. Експериментальні результати показали адекватність запропонованого підходу - було отримано маски, якість яких достатня для локалізації дефектів. Результати були оцінені за метрикою Dice: класична схема тренування - 0.621, запропонований підхід - 0.465. Проте запропонований метод потребує значно менше ресурсів в порівнянні з підходам класичного навчання та багатьма підходами часткового навчання.

Блок інформації про статтю

Ця робота ліцензується відповідно до Creative Commons Attribution 4.0 International License.

Автори, які публікуються у цьому журналі, погоджуються з наступними умовами:- Автори залишають за собою право на авторство своєї роботи та передають журналу право першої публікації цієї роботи на умовах ліцензії Creative Commons Attribution License, котра дозволяє іншим особам вільно розповсюджувати опубліковану роботу з обов'язковим посиланням на авторів оригінальної роботи та першу публікацію роботи у цьому журналі.

- Автори мають право укладати самостійні додаткові угоди щодо неексклюзивного розповсюдження роботи у тому вигляді, в якому вона була опублікована цим журналом (наприклад, розміщувати роботу в електронному сховищі установи або публікувати у складі монографії), за умови збереження посилання на першу публікацію роботи у цьому журналі.

- Політика журналу дозволяє і заохочує розміщення авторами в мережі Інтернет (наприклад, у сховищах установ або на особистих веб-сайтах) рукопису роботи, як до подання цього рукопису до редакції, так і під час його редакційного опрацювання, оскільки це сприяє виникненню продуктивної наукової дискусії та позитивно позначається на оперативності та динаміці цитування опублікованої роботи (див. The Effect of Open Access).

Посилання

C. Gh. Amza, G. Amza, and D. Popescu, “Image Segmentation for Industrial Quality Inspection,” Fiabilitate şi Durabilitate, no. 01.Supliment, pp. 126–132, 2012, URL: https://www.utgjiu.ro/rev_mec/mecanica/pdf/2012-01.Supliment/21_Catalin%20Amza,%20Gheorghe%20Amza,%20Diana%20Popescu.pdf.

R. Azad, N. Khosravi, M. Dehghanmanshadi, J. Cohen-Adad, and D. Merhof, “Medical Image Segmentation on MRI Images with Missing Modalities: A Review,” Mar. 2022, DOI: https://doi.org/10.48550/arxiv.2203.06217

K. Prakash, P. Saravanamoorthi, R. Sathishkumar, and M. Parimala, “A Study of Image Processing in Agriculture,” International Journal of Advanced Networking and Applications - IJANA, vol. 9, no. 1, pp. 3311–3315, 2017, URL: https://www.ijana.in/v9-1.php#.

W. Weng and X. Zhu, “U-Net: Convolutional Networks for Biomedical Image Segmentation,” IEEE Access, vol. 9, pp. 16591–16603, May 2015, DOI: https://doi.org/10.48550/arXiv.1505.04597 DOI: https://doi.org/10.1109/ACCESS.2021.3053408

V. Iglovikov and A. Shvets, “TernausNet: U-Net with VGG11 Encoder Pre-Trained on ImageNet for Image Segmentation,” Jan. 2018, DOI: https://doi.org/10.48550/arxiv.1801.05746

Z. Zhou, M. M. Rahman Siddiquee, N. Tajbakhsh, and J. Liang, “UNet++: A Nested U-Net Architecture for Medical Image Segmentation,” Lecture Notes in Computer Science (including subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics), vol. 11045 LNCS, pp. 3–11, Jul. 2018, DOI: https://doi.org/10.48550/arxiv.1807.10165

T.-Y. Lin, P. Dollár, R. Girshick, K. He, B. Hariharan, and S. Belongie, “Feature Pyramid Networks for Object Detection,” Dec. 2016, DOI: https://doi.org/10.48550/arxiv.1612.03144

L. E. Aik, T. W. Hong, and A. K. Junoh, “A New Formula to Determine the Optimal Dataset Size for Training Neural Networks,” ARPN Journal of Engineering and Applied Sciences, vol. 14, no. 1, pp. 52–61, Jan. 2019, URL: http://www.arpnjournals.org/jeas/research_papers/rp_2019/jeas_0119_7525.pdf

S. Dridi, Unsupervised Learning - A Systematic Literature Review. 2021, URL: https://www.researchgate.net/publication/357380639_Unsupervised_Learning_-_A_Systematic_Literature_Review

K. S. Kalyan, A. Rajasekharan, and S. Sangeetha, “AMMUS : A Survey of Transformer-based Pretrained Models in Natural Language Processing,” Aug. 2021, DOI: https://doi.org/10.48550/arxiv.2108.05542

E. Arazo, Di. Ortego, P. Albert, N. E. O’Connor, and K. McGuinness, “Pseudo-Labeling and Confirmation Bias in Deep Semi-Supervised Learning,” Proceedings of the International Joint Conference on Neural Networks, Aug. 2019, DOI: https://doi.org/10.48550/arxiv.1908.02983 DOI: https://doi.org/10.1109/IJCNN48605.2020.9207304

Y. Tay et al., “Are Pre-trained Convolutions Better than Pre-trained Transformers?,” ACL-IJCNLP 2021 - 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing, Proceedings of the Conference, pp. 4349–4359, May 2021, DOI: https://doi.org/10.48550/arxiv.2105.03322

R. R. Selvaraju, M. Cogswell, A. Das, R. Vedantam, D. Parikh, and D. Batra, “Grad-CAM: Visual Explanations from Deep Networks via Gradient-based Localization,” Int J Comput Vis, vol. 128, no. 2, pp. 336–359, Oct. 2016, DOI: https://doi.org/10.1007/s11263-019-01228-7

K. Simonyan and A. Zisserman, “Very Deep Convolutional Networks for Large-Scale Image Recognition,” 3rd International Conference on Learning Representations, ICLR 2015 - Conference Track Proceedings, Sep. 2014, DOI: http://doi.org/10.48550/arxiv.1409.1556

A. Krizhevsky, I. Sutskever, and G. E. Hinton, “ImageNet Classification with Deep Convolutional Neural Networks,” in Advances in Neural Information Processing Systems, 2012, vol. 25, URL: https://proceedings.neurips.cc/paper/2012/hash/c399862d3b9d6b76c8436e924a68c45b-Abstract.html

T. Pearce, A. Brintrup, and J. Zhu, “Understanding Softmax Confidence and Uncertainty,” Jun. 2021, DOI: https://doi.org/10.48550/arxiv.2106.04972

YU. P. Zaychenko, Osnovy proektuvannya intelektualʹnykh system. Navch. posibnyk. [Fundamentals of designing intelligent systems. Education manual.]. Kyiv: Vydavnychyy dim «Slovo», 2004

J. T. Springenberg, A. Dosovitskiy, T. Brox, and M. Riedmiller, “Striving for Simplicity: The All Convolutional Net,” 3rd International Conference on Learning Representations, ICLR 2015 - Workshop Track Proceedings, Dec. 2014, DOI: https://doi.org/10.48550/arxiv.1412.6806

“Severstal: Steel Defect Detection | Kaggle.” [Online]. Available: https://www.kaggle.com/c/severstal-steel-defect-detection

D. Berrar, “Cross-Validation,” in Encyclopedia of Bioinformatics and Computational Biology, Elsevier, 2019, pp. 542–545. DOI: https://doi.org/10.1016/B978-0-12-809633-8.20349-X

K. Namdar, M. A. Haider, and F. Khalvati, “A Modified AUC for Training Convolutional Neural Networks: Taking Confidence into Account,” Front Artif Intell, vol. 4, Jun. 2020, DOI: https://doi.org/10.3389/frai.2021.582928

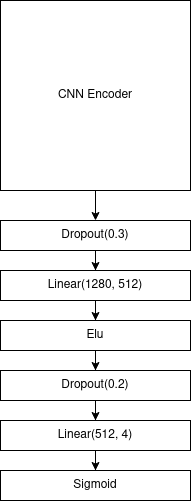

A. Labach, H. Salehinejad, and S. Valaee, “Survey of Dropout Methods for Deep Neural Networks,” Apr. 2019, DOI: https://doi.org/10.48550/arxiv.1904.13310

D. A. Clevert, T. Unterthiner, and S. Hochreiter, “Fast and Accurate Deep Network Learning by Exponential Linear Units (ELUs),” 4th International Conference on Learning Representations, ICLR 2016 - Conference Track Proceedings, Nov. 2015, DOI: https://doi.org/10.48550/arxiv.1511.07289

D. P. Kingma and J. L. Ba, “Adam: A Method for Stochastic Optimization,” 3rd International Conference on Learning Representations, ICLR 2015 - Conference Track Proceedings, Dec. 2014, DOI: https://doi.org/10.48550/arxiv.1412.6980

K. Mukherjee, A. Khare, and A. Verma, “A Simple Dynamic Learning Rate Tuning Algorithm For Automated Training of DNNs,” Oct. 2019, DOI: https://doi.org/10.48550/arxiv.1910.11605

M. Tan and Q. v. Le, “EfficientNet: Rethinking Model Scaling for Convolutional Neural Networks,” 36th International Conference on Machine Learning, ICML 2019, vol. 2019-June, pp. 10691–10700, May 2019, DOI: https://doi.org/10.48550/arxiv.1905.11946

S. Elfwing, E. Uchibe, and K. Doya, “Sigmoid-Weighted Linear Units for Neural Network Function Approximation in Reinforcement Learning,” Neural Networks, vol. 107, pp. 3–11, Feb. 2017, PMID: 29395652. DOI: https://doi.org/10.1016/j.neunet.2017.12.012

A. Chattopadhay, A. Sarkar, P. Howlader, and V. N. Balasubramanian, “Grad-CAM++: Generalized gradient-based visual explanations for deep convolutional networks,” Proceedings - 2018 IEEE Winter Conference on Applications of Computer Vision, WACV 2018, vol. 2018-January, pp. 839–847, May 2018, DOI: https://doi.org/10.1109/WACV.2018.00097

P. Izmailov, D. Podoprikhin, T. Garipov, D. Vetrov, and A. G. Wilson, “Averaging Weights Leads to Wider Optima and Better Generalization,” 34th Conference on Uncertainty in Artificial Intelligence 2018, UAI 2018, vol. 2, pp. 876–885, Mar. 2018, DOI: https://doi.org/10.48550/arxiv.1803.05407

D. Shanmugam, D. Blalock, G. Balakrishnan, and J. Guttag, “Better Aggregation in Test-Time Augmentation,” Proceedings of the IEEE International Conference on Computer Vision, pp. 1194–1203, Nov. 2020, DOI: https://doi.org/10.48550/arxiv.2011.11156 DOI: https://doi.org/10.1109/ICCV48922.2021.00125